Trong blog này, chúng tôi sẽ đề cập đến nội dung được cung cấp dưới đây:

- Làm cách nào để tùy chỉnh việc tạo văn bản bằng cách tải mô hình với chức năng “đường ống” từ Transformers?

- Làm cách nào để sử dụng Mô hình dựa trên máy biến áp để tạo văn bản trong PyTorch?

- Làm cách nào để sử dụng Mô hình dựa trên máy biến áp để tạo văn bản trong TensorFlow?

Làm cách nào để tùy chỉnh việc tạo văn bản bằng cách tải mô hình với chức năng “đường ống” từ Transformers?

Các ' đường ống ” được sử dụng để tự động tải xuống mô hình AI được đào tạo trước theo yêu cầu của người dùng. Để sử dụng chức năng đặc biệt này, người dùng cần cài đặt “ máy biến áp gói. Gói này cung cấp quyền truy cập vào các mô hình dựa trên Transformer tiên tiến nhất có thể thực hiện phân tích tình cảm cũng như nhiều mô hình khác Xử lý ngôn ngữ tự nhiên (NLP) nhiệm vụ.

Để xem minh họa thực tế của kịch bản được mô tả ở trên, hãy chuyển sang các bước dưới đây!

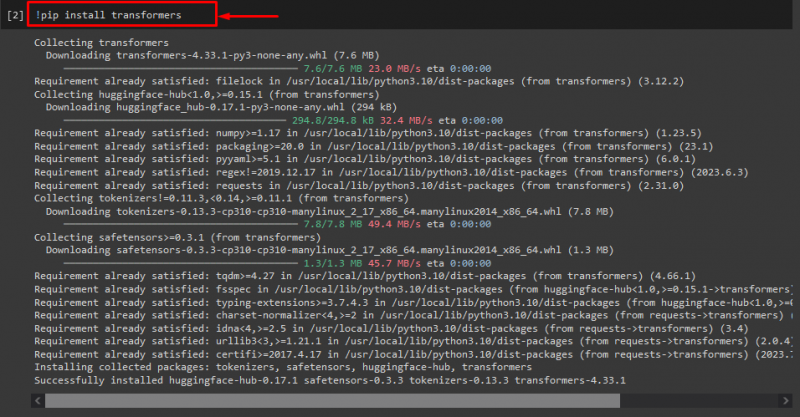

Bước 1: Cài đặt gói “máy biến áp”

Ban đầu, hãy thực thi lệnh “! pip” lệnh cài đặt các gói máy biến áp:

! pip cài đặt máy biến áp

Như bạn có thể thấy, gói được chỉ định đã được cài đặt thành công:

Bước 2: Nhập mô hình dựa trên máy biến áp

Sau đó, nhập mô hình dựa trên máy biến áp cần thiết. Để làm như vậy, trước tiên, hãy nhập “ đường ống ” chức năng từ “ máy biến áp ”. Tiếp theo, sử dụng hàm đã nhập và chuyển “ tạo văn bản ” làm đối số cho nó cùng với tên model được yêu cầu “ gpt2 ”. Tiếp theo, chuyển chúng đến “ phát ra ' Biến đổi:

từ máy biến áp nhập khẩu đường ống

phát ra = đường ống ( 'tạo văn bản' , người mẫu = 'gpt2' )

Bước 3: Tạo văn bản tùy chỉnh

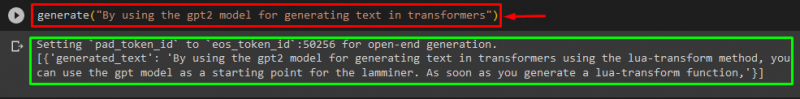

Bây giờ, chuyển văn bản mong muốn làm đối số cho “ phát ra ”. Như được hiển thị bên dưới:

phát ra ( 'Bằng cách sử dụng mô hình gpt2 để tạo văn bản trong máy biến áp' )Theo đầu ra được cung cấp, “ gpt3 ” mô hình đã được tạo văn bản thành công:

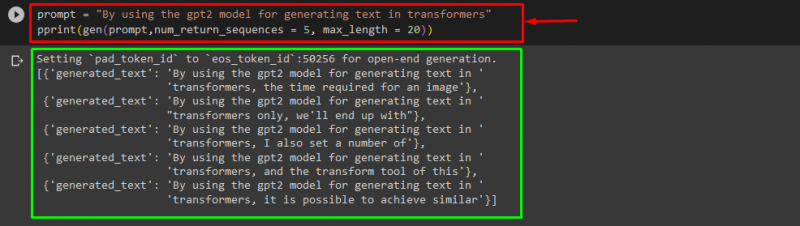

Bạn cũng có thể sử dụng các đối số khác, chẳng hạn như:

lời nhắc = 'Bằng cách sử dụng mô hình gpt2 để tạo văn bản trong máy biến áp'in ( gen ( lời nhắc , num_return_sequences = 5 , chiều dài tối đa = hai mươi ) )

Đây:

- “ lời nhắc ” được sử dụng làm đối số chứa đầu vào.

- “ num_return_sequence ” đối số được sử dụng để tạo ra số lượng chuỗi của văn bản được cung cấp.

- “ chiều dài tối đa Đối số ” được sử dụng để chỉ định độ dài của văn bản được tạo. Trong trường hợp của chúng tôi, nó được giới hạn ở “ 30 ” mã thông báo (từ hoặc dấu câu):

Ghi chú: Văn bản tùy chỉnh sẽ là phần tiếp theo của lời nhắc được chỉ định dựa trên dữ liệu huấn luyện của mô hình.

Làm cách nào để sử dụng Mô hình dựa trên máy biến áp để tạo văn bản trong PyTorch?

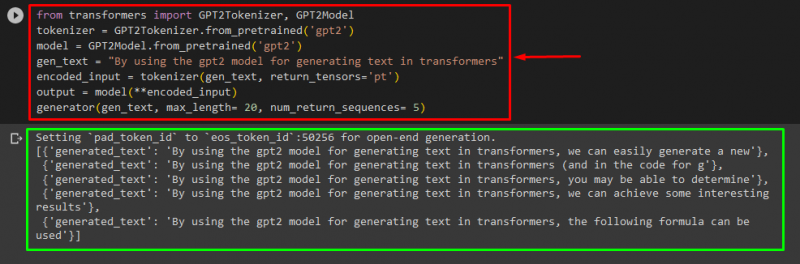

Người dùng cũng có thể tùy chỉnh văn bản trong “ PyTorch ” đó là “ Ngọn đuốc ” dựa trên khung học máy. Nó được sử dụng cho các ứng dụng khác nhau, chẳng hạn như NLP và Thị giác máy tính. Để sử dụng mô hình dựa trên máy biến áp để tùy chỉnh văn bản trong PyTorch, trước tiên, hãy nhập “ GPT2Tokenizer ' Và ' GPT2Mô hình ” chức năng từ “ máy biến áp ”:

từ máy biến áp nhập khẩu GPT2Tokenizer , GPT2Mô hìnhSau đó, sử dụng “ GPT2Tokenizer ” tokenizer theo mô hình được đào tạo trước mà chúng tôi mong muốn có tên là “ gpt2 ”:

mã thông báo = GPT2Tokenizer. from_pretrain ( 'gpt2' )Sau đó, khởi tạo các trọng số từ một mô hình được đào tạo trước:

người mẫu = Mô hình GPT2. from_pretrain ( 'gpt2' )Tiếp theo, khai báo một “ gen_text ” biến chứa văn bản mà chúng ta muốn tùy chỉnh:

gen_text = 'Bằng cách sử dụng mô hình gpt2 để tạo văn bản trong máy biến áp'Bây giờ, hãy vượt qua “ gen_text ' Và ' return_tensors='pt' ” làm đối số sẽ tạo văn bản trong PyTorch và lưu trữ giá trị được tạo trong “ mã hóa_input ' Biến đổi:

mã hóa_input = mã thông báo ( gen_text , return_tensor = 'pt' )Cuối cùng, vượt qua “ mã hóa_input ” biến chứa văn bản tùy chỉnh vào “ người mẫu ” làm tham số và nhận kết quả đầu ra bằng cách sử dụng “ chiều dài tối đa ” đối số được đặt thành “ hai mươi ” cho biết rằng văn bản được tạo sẽ bị giới hạn ở các mã thông báo được cung cấp, “ num_return_sequences ” được đặt thành “ 5 ” điều đó cho thấy văn bản được tạo sẽ dựa vào 5 chuỗi văn bản:

đầu ra = người mẫu ( ** được mã hóa_input )máy phát điện ( gen_text , chiều dài tối đa = hai mươi , num_return_sequences = 5 )

đầu ra

Làm cách nào để sử dụng Mô hình dựa trên máy biến áp để tạo văn bản trong TensorFlow?

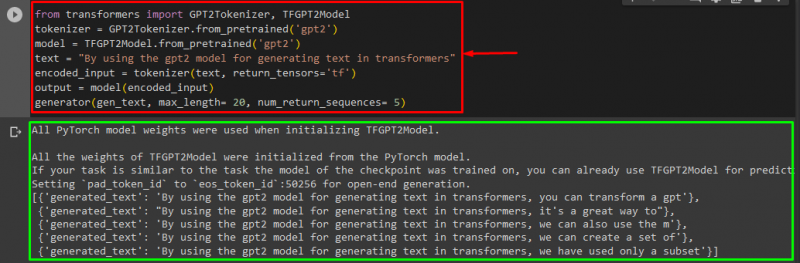

Để tạo văn bản trong Transformers, “ Dòng chảy căng ” Các khung học máy dựa trên cũng được sử dụng. Để làm như vậy, trước tiên, hãy nhập các hàm được yêu cầu, chẳng hạn như “ GPT2Tokenizer ' Và ' TFGPT2Mô hình ' từ ' máy biến áp ”. Phần còn lại của mã giống như trên, chỉ cần chúng tôi sử dụng “ TFGPT2Mô hình ” chức năng thay vì “ GPT2Mô hình ' chức năng. Như sau:

từ máy biến áp nhập khẩu GPT2Tokenizer , TFGPT2Mô hìnhmã thông báo = GPT2Tokenizer. from_pretrain ( 'gpt2' )

người mẫu = Mô hình TFGPT2. from_pretrain ( 'gpt2' )

chữ = 'Bằng cách sử dụng mô hình gpt2 để tạo văn bản trong máy biến áp'

mã hóa_input = mã thông báo ( chữ , return_tensor = 'tf' )

đầu ra = người mẫu ( mã hóa_input )

máy phát điện ( gen_text , chiều dài tối đa = hai mươi , num_return_sequences = 5 )

Như bạn có thể thấy, văn bản tùy chỉnh đã được tạo thành công:

Đó là nó! Chúng tôi đã xây dựng cách tùy chỉnh việc tạo văn bản trong Transformers.

Phần kết luận

Để tùy chỉnh việc tạo văn bản trong Transformers, có nhiều cách khác nhau như tải mô hình với chức năng đường ống, sử dụng mô hình dựa trên biến áp trong “ PyTorch ' Và ' Dòng chảy căng ” dựa trên các khuôn khổ học máy. Trong hướng dẫn này, chúng tôi đã cung cấp thông tin ngắn gọn cùng với phần trình diễn thực tế về cách tùy chỉnh việc tạo văn bản trong Transformers.