Cú pháp:

Vì chúng tôi đã quen thuộc với ChatGPT, chúng tôi biết rằng nền tảng này thuộc sở hữu của cộng đồng Open AI và nó cung cấp các công cụ, kiến trúc, API và một số khung mà chúng tôi có thể sử dụng trong việc triển khai các ứng dụng của mình và các mô hình xử lý ngôn ngữ tự nhiên. Open AI cung cấp các API mà qua đó chúng tôi có thể sử dụng bất kỳ mô hình AI và NLP được đào tạo trước nào từ nền tảng Open AI và có thể làm cho chúng hoạt động cho các ứng dụng của chúng tôi, chẳng hạn như để đưa ra dự đoán về dữ liệu thời gian thực. Tương tự như vậy, GPT4All cũng cho phép người dùng tích hợp các mô hình AI được đào tạo trước với các ứng dụng khác nhau.

Mô hình GPT4All được đào tạo trên dữ liệu hạn chế so với ChatGPT. Nó cũng có một số hạn chế về hiệu suất so với ChatGPT nhưng nó cho phép người dùng sử dụng GPT riêng của họ trên phần cứng cục bộ của họ và nó không yêu cầu bất kỳ kết nối mạng nào. Với sự trợ giúp của bài viết này, chúng ta sẽ biết cách có thể sử dụng các mô hình GPT4All trong tập lệnh Python vì GPT4All có các ràng buộc chính thức với Python, điều đó có nghĩa là chúng ta cũng có thể sử dụng và tích hợp các mô hình GPT4All thông qua tập lệnh Python.

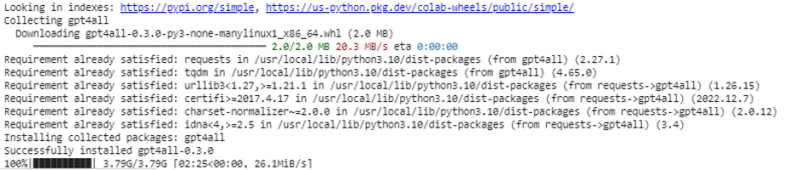

Tất cả đều cần một lệnh trực tuyến để cài đặt GPT4All cho Python IDE. Sau đó, chúng tôi có thể tích hợp nhiều mô hình AI như các ứng dụng của mình. Lệnh cài đặt GPT4All này bằng Python như sau:

$ pip cài đặt gpt4all

Ví dụ 1:

Để bắt đầu với ví dụ này, chúng ta cần tải xuống và cài đặt Python trong hệ thống của mình. Các phiên bản Python được đề xuất là “phiên bản 3.7” hoặc các phiên bản ra đời sau phiên bản này. Một cách khác để làm việc với Python để tránh mất nhiều thời gian cài đặt “thiết lập Python” trên hệ thống của chúng tôi là sử dụng “Google Colab”, một môi trường dựa trên đám mây dành cho Python. Chúng tôi có thể chạy môi trường này trên bất kỳ trình duyệt web nào và có thể xây dựng các mô hình AI và máy học. Các ví dụ mà chúng tôi sẽ triển khai ở đây được thực hiện trong Google Colab.

Ví dụ này đề cập đến phương pháp cài đặt GPT4All bằng Python và cách sử dụng các mô hình được đào tạo trước của nó. Chúng tôi bắt đầu bằng cách cài đặt GPT4All trước tiên. Đối với điều đó, lệnh mà chúng tôi đã đề cập trước đây được thực thi. Với việc thực thi lệnh, GPT4All cùng với các gói và khung của nó sẽ được tải xuống và cài đặt.

Bây giờ, chúng ta tiến về phía trước. Từ GPT4All, chúng tôi nhập “GPT4All”. Thao tác này sẽ thêm tất cả các mô hình được đào tạo trước từ GPT4All vào dự án. Bây giờ, chúng tôi có thể sử dụng bất kỳ mô hình đơn lẻ nào và làm cho nó thực hiện các dự đoán cho ứng dụng của chúng tôi. Sau khi chúng tôi nhập gói GPT4All, bây giờ là lúc gọi chức năng này và sử dụng mô hình GPT4All cung cấp đầu ra cho 'hoàn thành trò chuyện'.

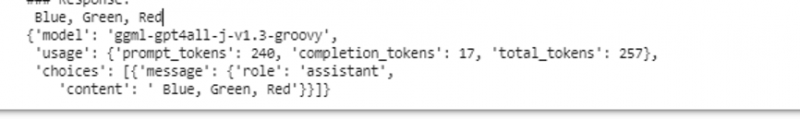

Nói cách khác, nếu chúng ta hỏi bất cứ điều gì từ mô hình đó ở đầu vào, nó sẽ trả về nó ở đầu ra. Mô hình mà chúng tôi sử dụng ở đây là “ggml-gpt4all-j-v1.3-groovy”. Các mô hình này đã được lưu trữ trong bộ nhớ đệm GPT4All. Chúng tôi có thể lấy các mô hình này từ liên kết này “ https://github.com/nomic-ai/gpt4all/tree/main/gpt4all-chat ” để tải xuống thủ công. Nếu mô hình đã có trong bộ nhớ đệm GPT4All, thì chúng ta chỉ cần gọi tên của mô hình và chỉ định tên đó làm tham số đầu vào cho hàm “GPT4All()”. Nếu chúng tôi đã tải xuống thủ công thành công, chúng tôi sẽ chuyển đường dẫn đến thư mục chứa mô hình. Vì mô hình này là để hoàn thành thông báo nên cú pháp cho mô hình này được đưa ra như sau:

$ Chat_completion (tin nhắn)Các thông báo là một danh sách từ điển và mỗi từ điển phải chứa khóa 'vai trò' có giá trị của người dùng, hệ thống hoặc trợ lý và nội dung 'khóa' có giá trị dưới dạng chuỗi. Trong ví dụ này, chúng tôi chỉ định nội dung là “tên ba màu” và khóa vai trò là “người dùng”.

$model= GPT4All('ggml-gpt4all-j-v1.3-groovy')$messages = [{'vai trò': 'người dùng', 'nội dung': 'Tên 3 loài hoa'}]

Sau thông số kỹ thuật này, chúng tôi gọi hàm “chat_completion()” với mô hình. Mã cho điều này được hiển thị trong đầu ra sau:

$ !pip cài đặt gpt4alltừ gpt4all nhập GPT4All

model = GPT4All('ggml-gpt4all-j-v1.3-groovy')

tin nhắn = [{'vai trò': 'người dùng', 'nội dung': 'Đặt tên ba màu'}]

model.chat_completion(tin nhắn)

Sau khi thực hiện ví dụ này, mô hình trả về ba màu dưới dạng phản hồi cho đầu vào.

Ví dụ 2:

Chúng tôi đề cập đến một ví dụ khác trong đó chúng tôi khám phá ra một phương pháp khác để sử dụng GPT4All trong Python. Điều này có thể được thực hiện bằng cách sử dụng các liên kết chính thức dành cho Python được cung cấp bởi “Nomic”, một cộng đồng AI nguồn mở và nó chạy GPT4All. Sử dụng lệnh sau, chúng tôi tích hợp “nomic” vào bảng điều khiển Python của mình:

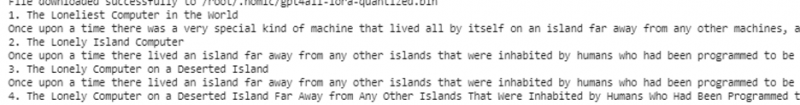

$ pip cài đặt kinh tếKhi điều này được cài đặt, chúng tôi nhập GPT4All từ “nomic.gpt4all”. Sau khi nhập GPT4All, chúng tôi khởi tạo GPT4All bằng hàm “open()”. Sau đó, chúng ta gọi hàm “prompt()” và chuyển lời nhắc cho hàm này. Sau đó, một phản hồi nhanh chóng được tạo dựa trên lời nhắc mà chúng tôi đã cung cấp làm đầu vào cho mô hình lời nhắc.

!pip cài đặt nomictừ nomic.gpt4all nhập GPT4All

# Khởi tạo mô hình GPT4All

bắt đầu = GPT4All()

bắt đầu.open()

# Tạo phản hồi dựa trên lời nhắc

model_response = started.prompt('viết một câu chuyện ngắn về máy tính)

# hiển thị phản hồi được tạo

in (model_response)

Đầu ra hiển thị phản hồi nhanh từ mô hình mà chúng tôi đã tạo bằng cách sử dụng mô hình GPT4All được đào tạo trước trong Python. Nếu chúng tôi muốn biết thêm về các mô hình và cách chúng tôi có thể sử dụng các mô hình này để tạo phản hồi hoặc nói một cách đơn giản, nếu chúng tôi muốn có kiến thức về cú pháp để tạo phản hồi từ các mô hình này, chúng tôi có thể nhận thêm trợ giúp từ GPT4Tất cả chi tiết tài liệu kỹ thuật.

Phần kết luận

GPT4All vẫn đang cố gắng đạt được độ chính xác về hiệu suất. Nó được điều hành bởi nền tảng AI thông thường nhằm mục đích cung cấp các chatbot thông minh nhân tạo cho người dùng trên CPU cấp người tiêu dùng vì GPT4All hoạt động mà không cần bất kỳ kết nối mạng và GPU nào. Bài viết này giúp chúng ta sử dụng thành thạo PyGPT4All trong môi trường Python và tạo ra sự tương tác giữa các ứng dụng của chúng ta với các mô hình AI của GPT4All đã được đào tạo trước. Chúng tôi đã đề cập đến hai phương pháp khác nhau về cách cài đặt GPT4All bằng Python trong hướng dẫn này.